从0到1打造数据可信的数据产品 解析数据治理在过程可信变革中的运作流程与数据处理服务

在数字化浪潮席卷各行各业的今天,数据已成为驱动决策、创新产品和优化服务的核心资产。数据的价值并非天然存在,只有当数据本身可信、处理过程可靠时,其产生的洞察与产品才能真正赋能业务,建立信任。本文将系统性地阐述如何从零开始构建一款数据可信的数据产品,并深入解析数据治理在此过程中的核心作用与运作流程,同时探讨数据处理服务如何支撑这一可信变革。

一、 起点:理解“数据可信”的基石

打造可信数据产品的第一步,是明确“可信”的内涵。它并非单一维度,而是贯穿数据全生命周期的综合体现:

- 数据质量可信:数据需准确、完整、一致、及时且符合业务定义。

- 过程处理可信:从采集、加工、计算到服务的每个环节,都应是可追溯、可审计、可复现且符合既定规则的。

- 安全合规可信:数据的访问、使用与共享必须建立在严格的权限控制、隐私保护(如GDPR、个保法)与行业合规框架之下。

- 业务价值可信:最终产出的数据产品或指标,必须与业务目标对齐,能够被业务方理解、信任并使用。

二、 核心引擎:数据治理在过程可信变革中的运作流程

数据治理并非一个独立的IT项目,而是确保数据产品从“0”到“1”乃至持续演进过程中,实现“过程可信”的战略性框架和持续运营机制。其运作流程可概括为以下几个关键阶段:

- 顶层设计与策略制定(Plan):

- 确立治理目标:明确数据产品要解决的核心业务问题,并据此定义数据可信的具体标准(例如,关键交易数据准确率需达99.99%)。

- 建立组织与职责:成立数据治理委员会,明确数据所有者(Data Owner)、数据管理员(Data Steward)和技术团队的角色与责任,确保权责清晰。

- 制定政策与标准:产出数据标准(命名、模型、质量规则)、数据安全与隐私政策、数据生命周期管理策略等核心纲领。

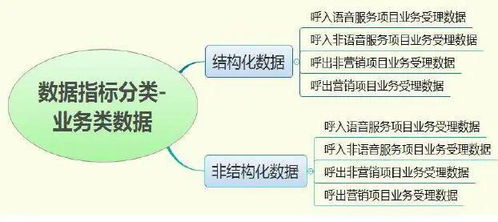

- 资产盘点与建模(Define):

- 数据资产目录:全面盘点数据源,形成统一的数据资产地图,明确数据的业务含义、来源、流向和责任人。这是实现可追溯性的基础。

- 统一数据模型:设计符合业务逻辑且标准化的概念模型、逻辑模型与物理模型,确保数据在跨系统、跨流程流转时语义一致。

- 过程嵌入与管控(Execute & Control):

- 质量规则引擎:将定义好的数据质量规则(如唯一性、有效性、及时性检查)嵌入数据处理流水线(如ETL/ELT),实现事前预防、事中监控与事后校验。

- 元数据与血缘管理:自动采集技术元数据、业务元数据与操作元数据,并建立端到端的数据血缘图。任何数据问题都可以快速定位源头和影响范围,极大增强过程透明度与可信度。

- 安全与访问控制:在数据处理各环节实施基于角色(RBAC)或属性(ABAC)的精细权限控制,对敏感数据实施脱敏、加密,并完整记录数据访问审计日志。

- 监控、度量与优化(Monitor & Improve):

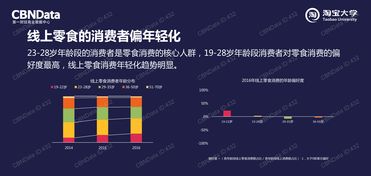

- 可信度度量体系:建立涵盖数据质量、处理时效、服务SLA、合规性等维度的度量指标和仪表盘,持续量化数据产品的可信水平。

- 闭环运维:对监控发现的质量问题、性能瓶颈或合规风险,启动标准化的问题跟踪、分派、修复与验证流程,形成治理闭环,持续提升过程可靠性。

三、 关键支撑:面向可信的数据处理服务

在上述治理流程的框架下,现代数据处理服务提供了实现“过程可信”的技术载体:

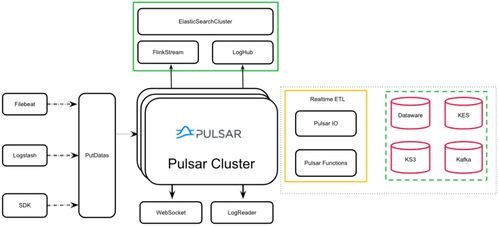

- 一体化数据平台:

- 提供从数据集成、存储、计算、治理到服务的一站式能力,确保技术栈统一,减少数据在复杂架构中流转带来的不可控风险。

- 可观测的数据流水线:

- 数据处理任务(如Airflow DAG、实时流作业)的状态、性能指标、日志以及数据血缘关系应被完整记录和可视化,使整个处理过程“白盒化”。

- 内置治理能力的计算引擎:

- 越来越多的云数据仓库(如Snowflake、BigQuery)和DataOps平台开始原生集成数据质量检查、血缘追踪、动态数据脱敏等功能,让可信能力成为数据处理的内生属性。

- 数据产品交付层:

- 通过数据API、分析仪表盘、机器学习模型服务等方式,将治理后的可信数据以产品化形态交付给最终用户。这一层同样需要治理,确保API的稳定性、指标口径的一致性和服务的可访问性。

四、 构建持续可信的飞轮

从0到1打造可信数据产品,是一个将数据治理理念深度融入产品构建与运营全过程的事业。它始于明确的业务目标与可信定义,成于体系化的治理流程运作,并以现代化的数据处理服务为坚实底座。这个过程并非一劳永逸,而是通过“设计-执行-监控-优化”的持续循环,形成一个不断自我强化的“可信飞轮”。当数据产品的消费者(无论是内部业务人员还是外部客户)能够无需质疑地使用数据做出决策时,数据才真正完成了从成本到可信资产的蜕变,成为驱动企业增长的核心引擎。

如若转载,请注明出处:http://www.zhizhenpay.com/product/55.html

更新时间:2026-02-27 16:00:47